Dlaczego ważne są technologie cyfrowe, skanowanie i digitalizacja dokumentów i książek i innych obiektów? Jakie jest uzasadnienie ogromnego wysiłku przekształcania spuścizny kulturowej w postać cyfrową? Często słyszę takie pytania – od historyków, którzy preferują zapach i dotyk oryginalnych dokumentów lub archiwistów, którzy twierdzą, że mikrofilmy są wystarczająco dobre. Czy cyfryzacja to tylko moda, która wkrótce przejdzie, czy też ma to głębsze uzasadnienie?

“Cyfrowe” jest ważne – dla archiwów, bibliotek, muzeów (GLAM) oraz dla wszystkich producentów i konsumentów dóbr kultury. Omówimy tu trzy powody przechodzenia do cyfrowego przetwarzania informacji: Zabezpieczanie, Znajdywalność (discoverablity) i Dostęp.

Zabezpieczanie

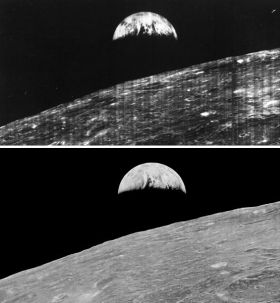

Układ cyfrowy jest tylko jedną z wielu implementacji dyskretnych systemów przechowywania i obróbki informacji. Większość sygnałów, które docierają do naszych zmysłów, np. widok tęczy, symfonia lub zapach róży, można uznać za analogowe. Sygnał analogowy może przyjąć dowolną wartość, na przykład dźwięku lub koloru. Zakres jest zazwyczaj ograniczony jedynie możliwościami naszych zmysłów – nie widzimy podczerwieni, ani słyszymy ultradźwięków itp. Ale sygnał optyczny, po tym jak wpadnie do naszego oka lub kamery cyfrowej, nie jest dalej przetwarzany jako sygnał ciągły. Czujniki światła w siatkówce (czopki i pręciki) działają na zasadzie “wszystko albo nic”, podobnie dzieje się w kamerze gdzie każdy element czujnika rozkłada światło na ograniczoną liczbę poziomów. Sygnał zostaje zmieniony w informację – wkraczamy tu w sferę dyskretności. W układzie dyskretnym tylko ograniczona, przeliczalna liczba stanów jest dozwolona, nie ma nic pomiędzy. W nowoczesnych komputerach cyfrowych podstawową jednostką informacyjną jest bit, który może posiąść tylko dwa stany (zwyczajowo zwane 0 i 1). Matematyczna teoria informacji, po raz pierwszy zaproponowana przez Claude E. Shannona, również używa jako jednostki binarnego bitu, z implikacją, że informacja w naturze swojej jest dyskretna. W komputerach, pojedyncze bity są zazwyczaj ułożone w grupy: 8 bitów w określonej kolejności nazywa się bajtem. W celu utrzymania ogólnego charakteru dyskusji, najmniejsza jednostkę systemu dyskretnego będziemy dalej nazywać znakiem, a ciąg znaków słowem.

Czytaj dalej „Dlaczego cyfrowo?”

10 czerwca 2014 r. Sąd Apelacyjny Drugiego Okręgu (południowy Nowy Jork) wydał wyrok, przychylając się do argumentów HathiTrust i odrzucając apel kilku organizacji autorskich, w tym m.in. amerykańskego Authors Guild i szwedzkiego Sveriges Författarförbund. W podsumowaniu wyroku czytamy:

10 czerwca 2014 r. Sąd Apelacyjny Drugiego Okręgu (południowy Nowy Jork) wydał wyrok, przychylając się do argumentów HathiTrust i odrzucając apel kilku organizacji autorskich, w tym m.in. amerykańskego Authors Guild i szwedzkiego Sveriges Författarförbund. W podsumowaniu wyroku czytamy: